Июн

Позиции сайта в поисковых системах

Привет, сегодня я хочу поговорить про позиции сайта в поисковых системах. Раньше я уже рассказывал, что необходимо писать статью, подбирая правильные поисковые запросы, чтобы в дальнейшем через поисковые системы приходило много посетителей. Но допустим мы пишем такие статьи, но посетители не идут, учитывая, что мы подбирали правильные запросы с нормальной посещаемостью в месяц, что делать?

Привет, сегодня я хочу поговорить про позиции сайта в поисковых системах. Раньше я уже рассказывал, что необходимо писать статью, подбирая правильные поисковые запросы, чтобы в дальнейшем через поисковые системы приходило много посетителей. Но допустим мы пишем такие статьи, но посетители не идут, учитывая, что мы подбирали правильные запросы с нормальной посещаемостью в месяц, что делать?

Для этого я рекомендую анализировать конкуренцию, а если быть точным узнать позиции запросов, на которых делался акцент в статье. Для анализа позиций сайта в поисковых системах по запросам существуют специальные сервисы, программы, сайты, скрипты и многое другое.

Зачем анализировать позиции сайта в поисковых системах?

— Если вы решили поэкспериментировать с улучшением позиции статьи в поисковике с помощью внешних (закупка ссылок и т.д.) или внутренних манипуляций, вам с начало необходимо отметить позицию до эксперимента и после, насколько ваши действия способствовали улучшению позиций. Ведь основной трафик приходиться на ТОП 10, 80% которого на ТОП 3 сайта.

— Чтобы знать на каком месте расположен запрос, который постоянно приносит посетителей, возможно, стоит его прогнать через агрегаторы (Webeffector, Rookee, MegaIndex и Seopult) или прикупить немного ссылок (Ротапост, Блогун, Казапа, Gogetlinks), чтобы в пару раз улучшить посещаемость с запроса.

— Если вы делаете сайты MFA, который будет вам приносить деньги от контекстной рекламы, тогда вам необходимо будет выводить страницы сайта в ТОП, чтобы улучшить прибыль.

— Если вы участвуете в конкурсе по продвижению определенного запроса или страницы, вам необходимо знать на каком месте вы сейчас находитесь в поисковой системе, чтобы приложить усилий и улучшить свое место в поисковике, к примеру, я участвует в конкурсе продвижение неизбежно, где необходимо быть в топ 50 по данному запросу.

Можно еще много написать причин, для чего необходимо отслеживать позиции сайта, но поговорим про методы фиксации позиций.

В основном анализ позиций сайта определяется с помощью сайтов (к примеру, seolib) или программ. Каждый из этих способов имеет свои плюсы и минусы, но сегодня я хочу акцентировать свое внимание именно на определение позиций сайта программой, потому что стоимость услуги, используя сервисы в интернете, зависит от числа заданных запросов и систем для анализа позиций в них. К примеру, за 80 запросов, которые анализируются в пяти поисковых системах, обойдется за месяц примерно в 5 долларов. А если запросов на много больше, или вы ведете не один сайт, то цена будет расти, поэтому лучше воспользоваться софтом и заплатить один раз, чтобы, сколько хотите столько и анализируйте запросов.

Программы тоже бывают разные, как платные, так и бесплатные (в статье про seo софт я упоминал пару таких, в будущем будет отдельная статья под бесплатные способы для анализа поисковых запросов).

Но бесплатные программы имеют минусы относительно платного софта, поэтому сегодня я свое внимание буду акцентировать на программе serp parser, на которую наткнулся, недавно читая Терехова.

Программа serp parser с первого взгляда была понятна для меня благодаря своему интерфейсу, так же на сайте можно найти подробную инструкцию с иллюстрациями по работе с программой. Но сам я тоже опишу основу работы с программой в виде иллюстраций.

После того как вы скачали и запустили программу (есть возможность 14 дней поработать бесплатно) в левом верхнем углу нажимаем на белый лист, который позволит создать новый проект.

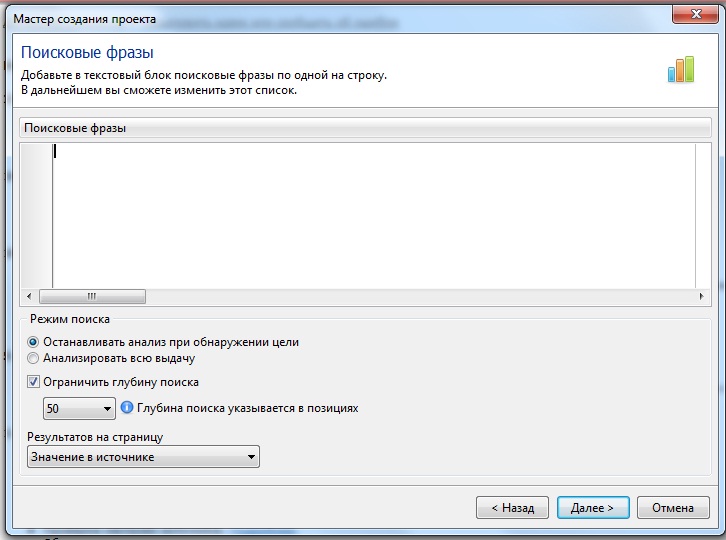

В поле необходимо вбить поисковые запросы, которые вы хотите проверить для своего сайта или для сайта конкурента. Поисковые запросы вы можете взять с основных ключевых слов, на которых базируются ваши статьи, взять их со статистики счетчиков посещаемости или как я проставил все ключевые слова, которые вы прописали в SEO in ONE или подобных плагинов на ворпдерсс.

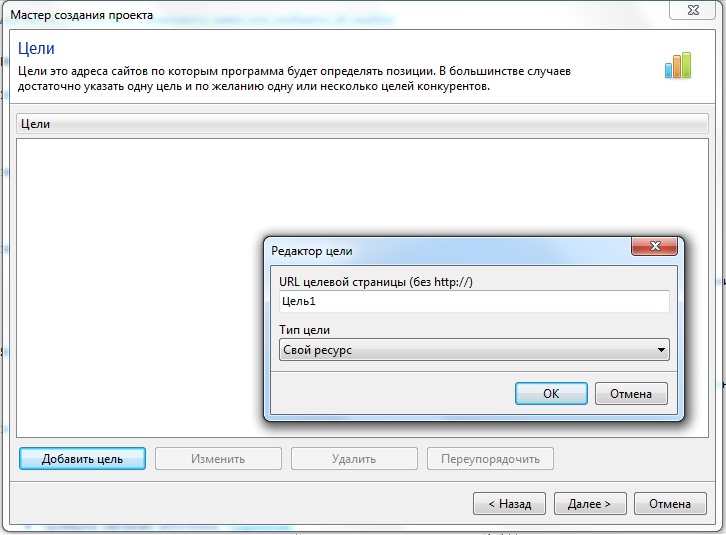

На втором шаге необходимо указать цели для анализа запросов, то есть сайты, для которых определиться та или иная позиция. На этом шаге можно указать как свои сайты для отслеживания, так и сайты конкурентов.

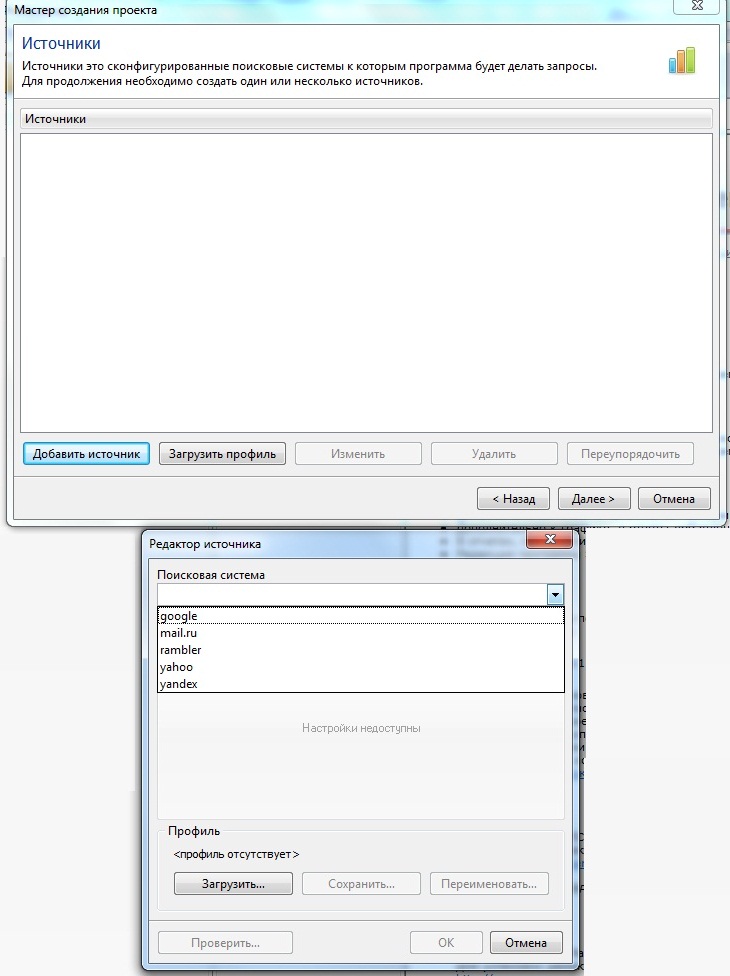

На третьем шаге необходимо указать источники для анализа, то есть те поисковые системы и их регионы которые нам необходимы. В наличии у программы есть 5 поисковых систем – google, yandex, mail rambler, yahoo. Я для анализа выбираю google и устанавливаю по очереди 3 доменных зоны – com, ru, com.ua и для yandex доменную зону для России и Украины.

После того как вы указали все нужные данные вам предложат сохранить проект и в дальнейшем вы сможете начать анализировать по этой программе. Для этого в главном меню вверху кликаем на четвертую кнопку, которая выглядит в виде перевернутого треугольника на зеленом фоне и тогда начнется процесс анализа, который будет выглядеть так.

Так же можно проанализировать по многим параметров используя графики ваши поисковые запросы. Программа мне понравилась в плане капчи, у меня за поиск 900 запросов вылезло только 40 капч, а если самому лень вбивать нужные знаки можно использовать antigate, где за 1 долларов программа распознает и введет 1000 капч.

Позднее проекты можно будет улучшать, видоизменять. Так же если посмотреть на новости сайта программы, то видно, что над ней работают, и каждый месяц новые фишки появляются в ней. Программа serp parser платная и есть два вида лицензии – для анализа одного проекта (в проекте может быть много сайтов и запросов для анализа) – 290 рублей в год или профессиональная версия, без каких либо ограничений – 890 рублей.

На этом первую статью из серии про анализ позиций сайта я заканчиваю, будет еще статья про бесплатные программы по анализу, про сайты по анализу позиций и еще одну полезную, но для её написания понадобиться мне примерно месяц.

*** ТИЦ 210 ПР 5, *** ТИЦ 750 ПР 5, заходим на сайт и регистрируемся, во время регистрации заполняем нужные поля и добавляем в аддурилку. Прочитать, как осуществить данную операцию по добавлению жирной ссылки в аддурилку.

Жирная ссылка живет два дня, чтобы их не пропустить подписывайтесь на блог!

Как жизнь проноситься перед глазами у гонщиков...

290 рублей за год (для одного сайта)? В принципе — купить чтоль ее себе?

Вопрос определения позиций сайта в поисковиках для меня тоже очень интересен. К тем причинам, которые ты перечислил — я бы еще добавил одну: Это интересно. Интересно знать, на каком ты месте (может это интересно для меня потому, что я новичок еще).Пойду этот серппарсер качать.

[Ответить]

Ahawks Reply:

июня 23, 2011 at 22:45

Если у тебя только один сайт то можешь приобрести... но с начало рекомендую просто скачать и 14 дней поработать бесплатно, как это сделал я.

[Ответить]

Ahawks Reply:

июня 24, 2011 at 10:10

Я ошибся 290 рублей в год для одного проекта, а сайтов там много может быть...

[Ответить]

Как раз хочу заняться своими позициями.

Спасибо.

[Ответить]

Ahawks Reply:

июня 24, 2011 at 09:41

будут вопросы обращайтесь

[Ответить]

Спасибо за информацию. Надо попробовать.

Но у меня проблема: как только займусь анализом сайтов, так про всё забываю...и про сайты тоже...)))

Вчера зашла на бесплатный оптимизатор сайтов и пока все 13 позиций изучила...утро наступило...:-)

[Ответить]

Ahawks Reply:

июня 24, 2011 at 10:38

Бывает, первые шаги всегда тяжелые, но потом будет на много легче) а что за «бесплатный оптимизатор сайтов» ?

[Ответить]

Ekaterina Reply:

июня 24, 2011 at 12:46

Так и пробейте в поиске «бесплатный оптимизатор сайтов», он выйдет на первой строке optimizatorsaita.ru , там анализ по 13 позициям с оценкой и рекомендациями.

[Ответить]

Ahawks Reply:

июня 25, 2011 at 18:40

что то полезное можно взять с данного сервиса для себя, спс

[Ответить]

Михаил Бондаренко Reply:

июля 10, 2011 at 10:43

Перепугал ваш оптимизатор меня до полусмерти Проверил свой блог через него, получился прямо Г.С. какой то В индексе яндекса ни одной страницы! Проверил через яндекс вебмастер, — все ок.

Проверил свой блог через него, получился прямо Г.С. какой то В индексе яндекса ни одной страницы! Проверил через яндекс вебмастер, — все ок.

[Ответить]

Ekaterina Reply:

июля 10, 2011 at 12:51

Это полезный шок Чтобы хотя бы на время отбить желание зависнуть на анализе:-)

Чтобы хотя бы на время отбить желание зависнуть на анализе:-)

Прогоните свой сайт по разным анализаторам и инфаркт обеспечен.

Всё же читатели — главный показатель у сайта для людей.

[Ответить]

А я сайт-аудитором пользуюсь для таких целей, проверяю не очень часто, так что думаю у меня нет надобности покупать serp parser для анализа позиций.

[Ответить]

Ahawks Reply:

июня 25, 2011 at 18:41

Тоже правильно, можно и бесплатные средства использовать для анализа если не так профессионально заниматься сайтом.

[Ответить]

Уже полез анализировать «бесплатнім анализатором сайтов». СПС,

[Ответить]

Для анализа своего блога я использую бесплатную прогу Site-Auditor. Вполне хорошая программа, а главное бесплатная.(написана нашими программистами)

[Ответить]

Ahawks Reply:

июля 11, 2011 at 14:14

Следующая статья будет посвящена парой программ для бесплатного анализа... так что альтернатива есть всегда

[Ответить]